È molto recente la notizia che racconta di un uomo di sessant’anni che è arrivato addirittura a sviluppare un’intossicazione da bromuro di sodio, anche definita Bromismo, dopo aver seguito un consiglio da parte di ChatGPT.

Nello specifico, l’uomo – che aveva a quanto pare deciso di eliminare il sale da cucina dalla sua dieta – ha chiesto all’intelligenza artificiale di suggerirgli un sostituto. Il suggerimento offerto pare sia stato proprio il bromuro di sodio. La sua assunzione prolungata (circa 3 mesi) si è trasformata in una pericolosa sindrome riconosciuta successivamente in ospedale.

Il fatto è stato raccontato all’interno della rivista medica statunitense Annals of Internal Medicine, ma è importante che sia diffuso per porre ulteriormente l’attenzione sulla necessità di vagliare ogni singola informazione ottenuta tramite l’intelligenza artificiale.

Ascolta ChatGPT e finisce in ospedale: il caso

Dopo ben tre mesi di assunzione di bromuro di sodio, l’uomo si è recato in ospedale con sintomi decisamente singolari. Tra questi c’era principalmente la paranoia. Addirittura, prima di essere stabilizzato, il paziente ha tentato la fuga dall’ospedale. Tra gli altri sintomi manifestati, anche una sete eccessiva e dell’acne sul viso.

Nel momento in cui è stato possibile dialogare in modo più calmo con l’uomo, in ospedale si sono resi conto che era solito seguire alcune regole alimentari specifiche. Fra queste, è emersa la sostituzione del sale (cloruro di sodio) con il bromuro di sodio. A quanto pare, è stata proprio l’intelligenza artificiale – nello specifico ChatGPT – a suggerire questo elemento come sostituto del classico sale da cucina. Sembra però che non sia stato possibile accedere direttamente alla conversazione avuta dal paziente con il modello di AI. Di conseguenza, non è stato possibile capire a fondo quello che è successo: l’intelligenza artificiale potrebbe aver risposto in questo modo, dando per scontato che il bromuro di sodio non sarebbe stato utilizzato per scopi alimentari.

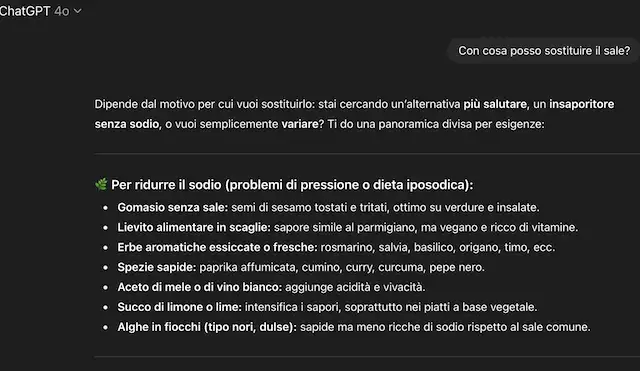

Anche noi abbiamo effettuato una prova direttamente su ChatGPT, ottenendo consigli sensati e non fuorvianti. Addirittura, abbiamo evitato di specificare “da cucina”, limitandoci alla frase: “con cosa posso sostituire il sale?”. C’è da specificare che abbiamo deciso di utilizzare un modello precedente di ChatGPT. Questo perché l’ultima versione, la numero 5, punta fra le altre novità anche a una maggiore consapevolezza nella gestione delle richieste e delle risposte relative al tema della salute.

A ogni modo, quello che è successo pone ulteriormente l’accento sull’importanza di valutare le informazioni ricevute dall’intelligenza artificiale, soprattutto quando si tratta di temi delicati e potenzialmente molto pericolosi come la salute.

I modelli di AI possono essere particolarmente utili, ma le informazioni ricavate vanno interpretate e sapute gestire. Un errore come quello commesso dall’uomo protagonista di questa storia può rivelarsi anche fatale.