ChatGPT Salute, la recente novità lanciata da OpenAI con l’obiettivo di supportare gli utenti nei percorsi di assistenza medica (ad esempio integrando documentazioni sanitarie), è finito sotto i riflettori, sollevando dubbi sulla reale affidabilità dell’Intelligenza Artificiale in campo sanitario. Test recentemente condotti, infatti, evidenziano i limiti dell’AI quando si tratta di interpretare dati medici sensibili: si riaccende così il dibattito su come questi sistemi dovrebbero essere, effettivamente, utilizzati.

AI e salute: un’arma a doppio taglio?

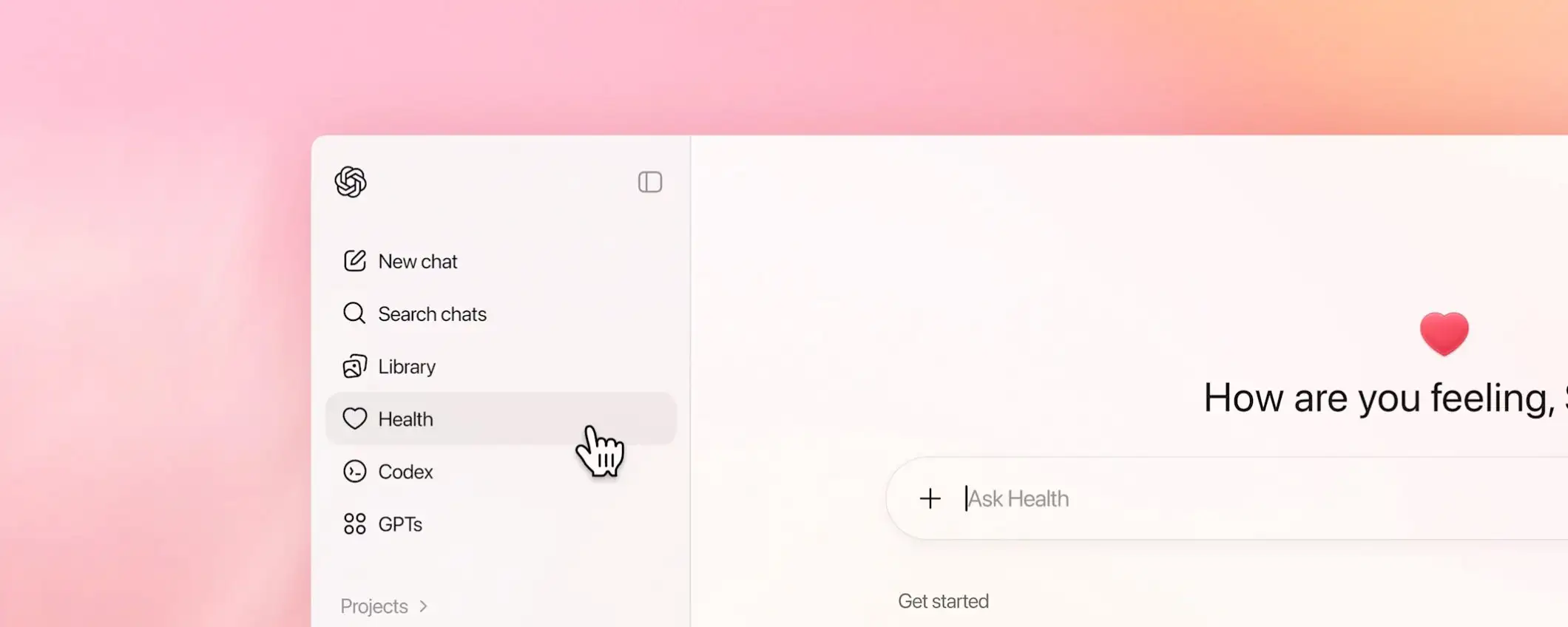

La fase di test per ChatGPT Salute è iniziata nel corso del mese di gennaio: questa sezione, che trova posto all’interno del chatbot, è pensata per gestire dati personali e referti sanitari dell’utente. Ma non solo, perché può anche collegarsi ad app di terze parti come Apple Health, con l’obiettivo di fornire risposte più personalizzate basate sui dati dell’utente. L’azienda ha ribadito che la funzione è opzionale e progettata per informare, non per diagnosticare, né sostituire il parere di un medico.

Per valutarne l’efficacia, un giornalista del Washington Post ha deciso di testarlo importando dati a lungo termine provenienti da Apple Watch. Il risultato è apparso fin da subito allarmante: l’AI, infatti, ha indicato un’elevata probabilità di malattie cardiache. Dato poi smentito da un medico in carne ed ossa, che ha invece affermato il contrario, ovvero un rischio molto basso.

Questo test è servito a mostrare agli utenti come l’Intelligenza Artificiale possa dare un’errata interpretazione basandosi su dati grezzi, fornendo valutazioni senza un contesto clinico specifico. Un cardiologo dello Scripps Research Institute ha definito il report redatto da ChatGPT privo di basi scientifiche. Il monito è di fare attenzione, per quella che appare a tutti gli effetti un’arma a doppio taglio: risultati negativi forniti dall’AI potrebbero generare panico ingiustificato, mentre al tempo stesso valutazioni positive potrebbero indurre un falso senso di sicurezza,

Un ulteriore aspetto riguarda l’incoerenza delle risposte: ponendo più volte la stessa domanda con gli stessi dati medici, il chatbot ha restituito valutazioni diverse e, in alcuni casi, ha dimenticato informazioni di base, come età e genere dell’utente, nonostante fossero presenti nella conversazione. Per diagnosi e trattamenti, ricorrere a un medico vero resta sempre l’opzione più affidabile.